-

科研进展 | 张东晓研究团队与陈云天研究团队合作发表语义可解释人工智能的新框架

最新新闻 | 2022-12-22

近期,东方理工/南方科技大学张东晓研究团队与东方理工陈云天研究团队合作,提出了一种语义可解释人工智能(semantic explainable AI, S-XAI)的研究框架,从语义层面解释了CNN的学习机制,并以猫狗二分类问题为例,形象地揭示了模型是如何学习类别意义上的猫的概念,即「何以为猫」。该研究以《Semantic interpretation for convolutional neural networks: What makes a cat a cat?》为题,作为封面文章发表于《Advanced Science》上。

近年来,CNN因其优异的性能,在计算机视觉、自然语言处理等各个领域受到了研究者们的青睐。但是,CNN是一个「黑盒」模型,即模型的学习内容和决策过程很难用人类能够理解的方式提取和表达,这限制了它的预测可信度和实际应用。因此,CNN的可解释性受到了越来越多的关注,研究者们试图采用特征可视化,网络诊断和网络架构调整等方式辅助解释CNN的学习机制,从而将这一「黑盒」透明化,使人类更容易理解、检测和改进其决策过程。

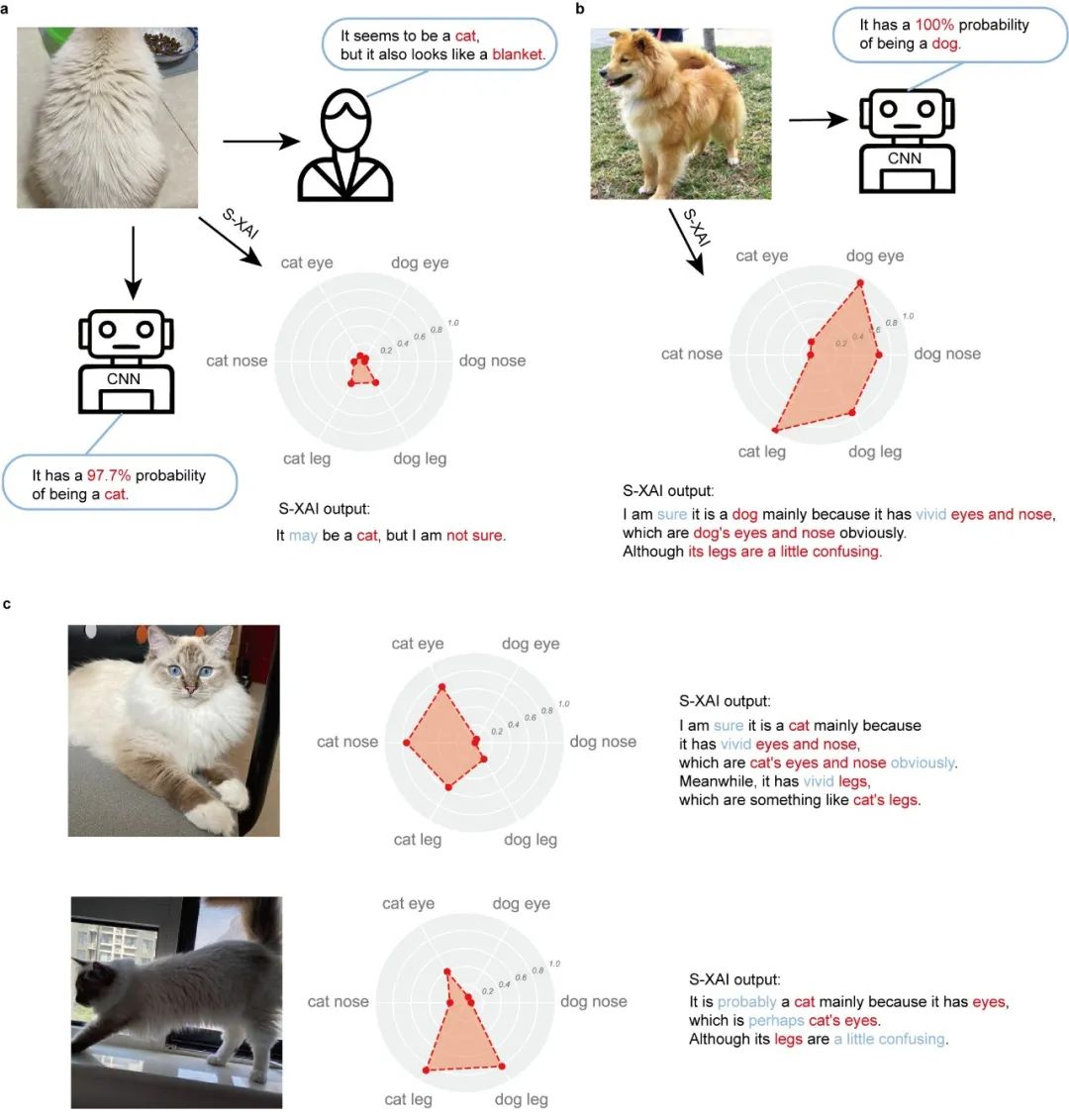

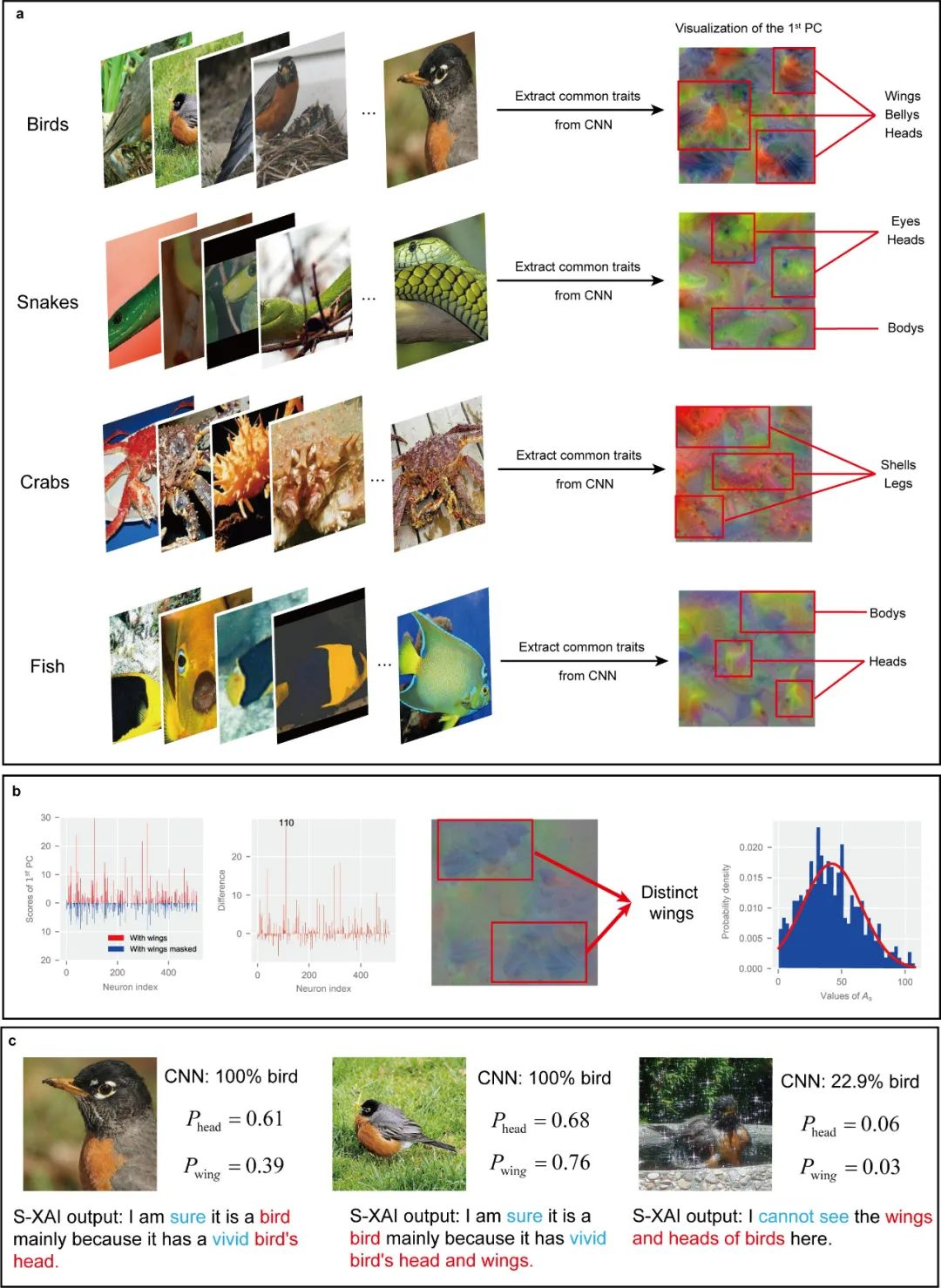

该研究聚焦于CNN从同一类别的样本中学习到的共性特征,并提取出人类可理解的语义概念,为CNN提供了语义层面的解释。基于此,研究首次提出了「语义概率(semantic probability)」的概念来表征语义要素在样本中的出现概率。实验表明,S-XAI 在二分类和多分类任务中均能成功地提取共性特征并抽象出超现实但可辨认的语义概念,在可信度评估和语义样本搜索等层面有着广泛的应用前景。

研究中提出的语义可解释人工智能(S-XAI)通过提取共性特征和语义空间,从语义层面上为CNN的类别识别机制提供了解释。该研究框架无需改变CNN的架构即可获取一定的全局解释能力,由于不涉及网络的重新训练,S-XAI具有响应速度较快的优势,在可信度评估和语义样本搜寻方面有着可观的应用潜力。

S-XAI 自动生成的语义概率雷达图和解释语句

本质上而言,S-XAI 与知识发现有着异曲同工之处。知识发现意图从神经网络找出反映共性物理规律的函数项,S-XAI 则是从CNN 中找出反映样本共性特征的语义空间,二者的核心思想均为寻找共性并将其表示出来,尽可能的让人类可以理解。

S-XAI 在多分类任务中的表现

该研究由东方理工/南方科技大学张东晓团队与东方理工陈云天团队合作完成。团队中的北京大学博士生徐浩为第一作者,张东晓与陈云天为共同通讯作者。该研究得到深圳国家应用数学中心(NCAMS)、深圳市天然气水合物重点实验室(基金号:ZDSYS20200421111201738)和南方科技大学青岛新能源技术研究院的经费支持。

论文原文链接:https://onlinelibrary.wiley.com/doi/10.1002/advs.202204723